Nepnieuws (Fake news, gaslighting) verwijst naar valse of misleidende informatie die als nieuws wordt gepresenteerd, vaak met de bedoeling lezers of kijkers te misleiden. Het kan verschillende vormen aannemen, waaronder verzonnen verhalen, verdraaide feiten, gemanipuleerde afbeeldingen of video’s en misleidende krantenkoppen. Nepnieuws wordt doorgaans gecreëerd en verspreid via sociale mediaplatforms, websites en andere onlinekanalen, hoewel het ook in traditionele mediabronnen kan voorkomen.

De verspreiding van nepnieuws kan ernstige gevolgen hebben, waaronder de vervorming van het publieke debat, de erosie van het vertrouwen in de media en de verspreiding van desinformatie. Het kan ook worden gebruikt als instrument voor propaganda-, manipulatie- en beïnvloedingscampagnes, vooral in de context van politieke of sociale kwesties.

Het is belangrijk voor consumenten van nieuws en informatie om de bronnen die ze tegenkomen kritisch te beoordelen en de juistheid van de inhoud te verifiëren voordat deze wordt gedeeld. Organisaties die feiten controleren en initiatieven op het gebied van mediageletterdheid spelen een cruciale rol bij het bestrijden van de verspreiding van nepnieuws en het bevorderen van een beter geïnformeerde en verantwoordelijke benadering van het consumeren van informatie.

In dit verband is onderstaand artikel uit het Bulletin of the Atomic Scientists waard om hier (vertaald en enigszins ingekort) te herhalen.

“Sociale media zijn een verbindende factor geweest tussen mensen dichtbij en ver weg, maar hebben ook:

- politieke conflicten aangewakkerd,

- democratische processen bedreigd,

- bijgedragen aan de verspreiding van desinformatie over de volksgezondheid en

- waarschijnlijk de geestelijke gezondheid van sommige tieners geschaad.

Gezien wat er de afgelopen jaren over deze platforms aan het licht is gekomen, wordt het steeds duidelijker dat de huidige vangrails – zowel overheidsregels als het interne beleid van de bedrijven – niet voldoende zijn om de problemen aan te pakken die de informatieomgeving teisteren. Maar om democratieën en hun burgers te laten floreren is een gezond virtueel ecosysteem noodzakelijk.

Een panel als het IPCC

Om dat te bereiken hebben experts een internationale inspanning nodig om beleidsmakers te verbinden met onderzoek door relevante onderzoeksstromen te verzamelen, samen te vatten en te destilleren.

Twee van dergelijke initiatieven, het International Panel on the Information Environment en het voorgestelde International Observatory on Information and Democracy, zijn begonnen aan dat doel te werken. Beiden zijn geïnspireerd door het Intergouvernementeel Panel voor Klimaatverandering (IPCC), een multinationale organisatie die een wetenschappelijk bureau kiest om evaluaties van klimaatonderzoek uit te voeren en beleidsaanbevelingen te doen.

Sinds de oprichting in 1988 heeft het IPCC de antropogene oorsprong van de klimaatverandering stevig bevestigd en beleidsaanbevelingen gedaan die de basis vormden van twee grote internationale overeenkomsten, het Kyoto-protocol van 1997 en de Overeenkomst van Parijs van 2015.

Beleidsmakers en onderzoekers hebben opgeroepen tot soortgelijke maatregelen om op onderzoek gebaseerd, mondiaal gecoördineerd beleid inzake de informatieomgeving en -voorziening te creëren.

Om dergelijke inspanningen te laten slagen, moeten ze echter kunnen putten uit een goed ontwikkelde onderzoeksbasis. Het eerste rapport van het IPCC, geschreven tussen 1988 en 1990, maakte gebruik van decennia van gestandaardiseerde metingen en onderzoeksinfrastructuur, waaronder:

- monitoring van kooldioxide in de atmosfeer,

- geavanceerde metingen van weerballonnen en meteorologische satellieten, en

- zestien jaar satellietbeelden van het aardoppervlak.

Deskundigen beschikken eenvoudigweg niet over dat soort diepgaand bewijsmateriaal over de informatieomgeving. Er is weinig consistentie in theoretische argumenten over hoe dit ecosysteem werkt, en gestandaardiseerde metingen en onderzoeksinstrumenten bestaan vrijwel niet. Om een IPCC-achtig orgaan op het gebied van de informatieomgeving zijn volledige potentieel te laten bereiken, moeten overheden en andere entiteiten substantiële investeringen doen in:

- datatoegang,

- gestandaardiseerde metingen en

- onderzoeksinstrumenten.

Om te onderzoeken hoe die investeringen eruit zouden moeten zien, is het nuttig om de huidige stand van het onderzoek naar de informatieomgeving te schetsen en de uitdagingen van het uitvoeren van hoogwaardige wetenschap onder de huidige status quo.

De stand van zaken

Ons team heeft een onderzoek uitgevoerd naar het werk dat tussen 2017 en 2021 is gepubliceerd in tien toonaangevende tijdschriften op het gebied van:

- communicatie,

- economie,

- politieke wetenschappen,

- informatica en

- sociologie,

- plus zes grote wetenschappelijke onderzoekspublicaties van algemeen belang.

We ontdekten dat het onderzoek zich concentreert op twee grote sociale mediaplatforms:

- Facebook en

- Twitter (nu X).

Onderzoekers zouden betrouwbaarder beleid kunnen leveren als ze het hele informatie-ecosysteem konden karakteriseren.

Uit onze steekproef van relevant academisch werk bleek echter dat 49 procent van de kranten uitsluitend Twitter-gegevens gebruikte, en 59 procent gebruikte deze in een of andere vorm, ondanks het relatief kleine aantal maandelijkse actieve gebruikers van de 436 miljoen in 2021.

Andere platforms

Grote platforms met grote wereldwijde gebruikers bases – waaronder YouTube, WeChat en Telegram – blijven kritisch onderbelicht. Terwijl er respectievelijk ongeveer 22,4 en 1,4 gepubliceerde artikelen per 100 miljoen actieve gebruikers voor respectievelijk Twitter en Facebook waren, trokken YouTube, WeChat en Telegram ondanks hun aanzienlijke gebruikersbasis veel minder onderzoek.

Maandelijks maken ongeveer 2,3 miljard mensen actief gebruik van YouTube. En WeChat en Telegram hebben respectievelijk 1,3 miljard en 550 miljoen actieve maandelijkse gebruikers.

Beperkingen

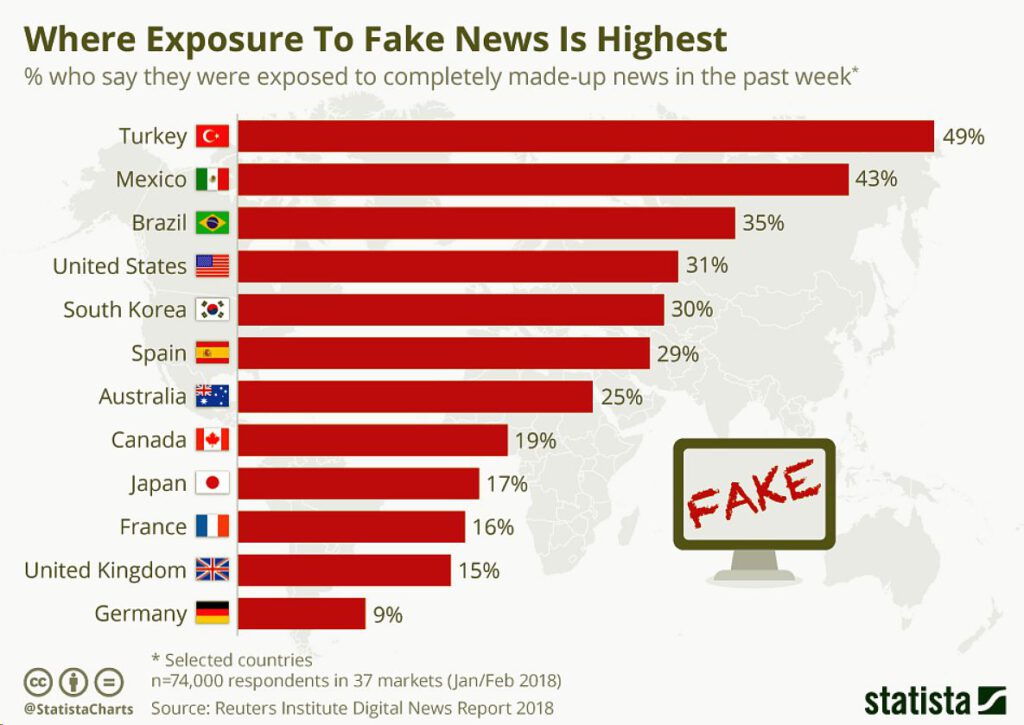

Naast de beperkte platformdekking is bestaand onderzoek ook geografisch en taalkundig beperkt. Vijfenzestig procent van de artikelen analyseert alleen een westerse democratie (de Verenigde Staten, EU-landen, Groot-Brittannië, Australië of Nieuw-Zeeland), waarvan meer dan de helft uitsluitend de Verenigde Staten bestudeert.

Bovendien analyseert 60 procent van de artikelen alleen Engelstalige gegevens. Dit betekent dat de meest bevolkte regio’s van de wereld het minst bestudeerd zijn, wat erop wijst dat er een ernstige behoefte is om onderzoek in en over Latijns-Amerika, Azië en Afrika mogelijk te maken.

In numerieke termen waren er 27,22 kranten per 100 miljoen inwoners in onze steekproef die uitsluitend gericht waren op de Verenigde Staten, de Europese Unie en Oceanië (voornamelijk Australië en Nieuw-Zeeland), terwijl de hele rest van de wereld vertegenwoordigd wordt door slechts 1,39 kranten per bevolking. 100 miljoen inwoners.

Geen consensus over onderzoekmethode

Het maken van beleidsaanbevelingen op mondiale schaal vereist een zekere mate van normale wetenschap: vaste, fundamentele resultaten die vorm kunnen geven aan het gerichte onderzoek en de experimenten die nodig zijn om prescriptieve remedies tegen online schade te ontwikkelen. Onderzoekers hebben bijvoorbeeld betoogd dat ‘pre-bunking’-interventies – die variëren van waarschuwingen dat een bericht of link mogelijk verkeerde informatie geeft, tot games die zijn ontworpen om spelers te leren hoe ze desinformatie in het wild kunnen opsporen – effectief zijn in het verminderen van het geloof in desinformatie. Recenter onderzoek stelt dat dit effect niet wordt veroorzaakt door een groter vermogen om verkeerde informatie te identificeren, maar eerder door een groter wantrouwen jegens alle informatie, inclusief feiten.

Gecombineerd zorgen het gebrek aan geografische dekking, het beperkte onderzoek op de meeste platforms en het ontbreken van fundamentele resultaten, ervoor dat dit vakgebied verre van in staat is het soort zeer betrouwbaar bewijsmateriaal op mondiale schaal te leveren waarop het IPCC zich baseerde voor zijn eerste beoordelingsrapport.

Huidige onderzoeksbokkades

Als onderdeel van een gezamenlijk initiatief van Princeton University en de Carnegie Endowment for International Peace heeft ons team 48 onderzoekers uit de academische wereld en het maatschappelijk middenveld uit meer dan twintig landen geïnterviewd om vast te stellen welke factoren de reikwijdte van onderzoek naar informatieomgevingen vertragen of verkleinen. (Sindsdien hebben we met bijna 200 extra onderzoekers samengewerkt.)

De grootste klacht van de onderzoekers was een gebrek aan voldoende toegang tot gegevens. Toen ze wel toegang hadden tot data, rapporteerden ze dat het gebrek aan technisch geschoold personeel of een infrastructuur die geschikt was voor big data – zoals de noodzakelijke dataverzameling, veilige opslag en vooral analysetools – het moeilijk maakte om deze data effectief te gebruiken.

De conclusie is duidelijk: om het beleidsvoordeel van IPCC-achtige instellingen te maximaliseren, moeten onderzoekers verder gaan dan het mogelijk maken van datatoegang en grote investeringen doen in onderzoeksinstrumenten die wetenschappers helpen data te gebruiken en het vakgebied vooruit te helpen.

Onderzoek draait op gegevens, die minder beschikbaar zijn geworden naarmate het veld van de informatieomgeving zich ontwikkelde. Afgelopen juni begon X (voorheen Twitter) onderzoekers $ 42.000 per maand in rekening te brengen voor toegang tot zijn datastroom, ondanks het feit dat ze minder data leverden dan een eerdere gratis versie van deze interface. Meta heeft grote hoeveelheden eerder beschikbare openbare gegevens onbeschikbaar gemaakt na het Cambridge Analytica-schandaal van 2018 en zei dat het zou stoppen met het updaten van zijn CrowdTangle-service, een door Meta geleverde datatool die onderzoekers toegang geeft tot de meeste publieke activiteiten op Facebook en een substantieel deel van Instagram .

Uiteraard gaat het bij datatoegang om meer dan alleen het kunnen downloaden van de informatie; het gaat ook om het functioneel toegankelijk maken voor een breder scala aan onderzoekers. Op dit moment zijn grote hoeveelheden gegevens slechts nuttig voor een kleine groep goed gefinancierde, zeer technisch vaardige onderzoekers. Uit onze interviews bleek dat wetenschappers te maken kregen met een reeks problemen die hun vermogen om data daadwerkelijk te analyseren beperkten, waaronder:

- het onvermogen om datawetenschappers en -ingenieurs in te huren,

- de noodzaak om zwaar te leunen op beginnende studenten om technische problemen op te lossen (ten koste van de eigen onderzoeksresultaten van die onderzoekers). agenda’s) en

- problemen bij het implementeren van de video-, beeld- en netwerkanalysemethoden die nodig zijn om verder te gaan dan tekst en een vollediger beeld van sociale-mediagegevens te krijgen.

Deze barrières worden weerspiegeld in de onderzoeksbasis: de meeste artikelen in onze steekproef zijn kleinschalige tot middelgrote analyses die uitsluitend uit tekst bestaan, waarbij zelden gebruik wordt gemaakt van geavanceerde machine learning of statistische methoden. En onderzoekers meldden dat ze vaak de reikwijdte van projecten verkleinden of volledig stopzetten vanwege een gebrek aan toegang tot gegevens of het onvermogen om de benodigde onderzoeksinstrumenten te creëren.”